การเดินทางของ AI ตลอดช่วง 3 ใน 4 ศตวรรษ จากปี 1950-2025 ผ่านความลุ่ม ๆ ดอน ๆ จากยุคเริ่มต้น รุ่งเรืองจุดประกายความหวังของนักวิทยาศาสตร์ สู่ยุคซบเซาซ้ำไปซ้ำมา กลับมาฟื้นฟู และเฟื่องฟูขึ้นจนกระทั่งปี 2024 ที่ Generative AI เติบโตขึ้น ใช้งานจริงได้อย่างเห็นผล และปี 2025 AI ยิ่งพัฒนาต่อไปอย่างก้าวกระโดด โดยเฉพาะ Agentic Workflow ขับเคลื่อนการทำงานด้วย Agent เฉพาะด้าน ไม่ต้องมีมนุษย์ควบคุมสั่งการ

จากคำกล่าวของ Andrew Ng ผู้ทรงอิทธิพลด้าน AI ที่ว่า AI ไม่ใช่ซอฟต์แวร์ แต่เป็นเหมือนไฟฟ้า ที่อินทิเกรตเข้ากับอะไรก็ได้ ทำให้สร้างนวัตกรรม มีผลต่อเศรษฐกิจลดค่าใช้จ่ายที่ไม่จำเป็นลง การเพิ่มศักยภาพของมนุษย์

พิพัฒน์ ประภาพรรณพงศ์ ผู้อำนวยการและหัวหน้าทีม Advanced Insights (AI) บริษัท บลูบิค กรุ๊ป จำกัด (มหาชน) บอกเล่าเทรนด์ AI มาแรง ปี 2025 ว่า ทีมบลูบิคนำแนวทางจาก Gartner บริษัทที่ปรึกษาชั้นนำระดับโลก มาวิเคราะห์ พบ 3 เทรนด์มาแรง คือ

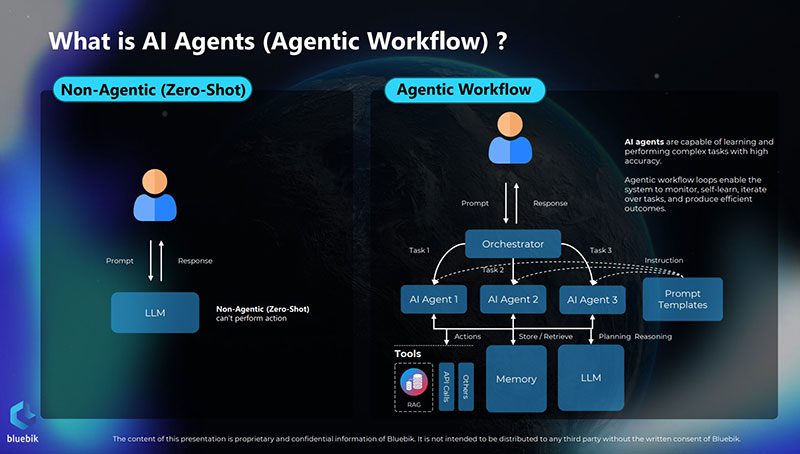

- AI Agentic Workflow เป็นการพัฒนาอีกขั้นต่อยอดจาก Non-Agentic เป็นระบบอัตโนมัติที่เรียนรู้และทำงานซับซ้อนได้เองโดยไม่ต้องใช้คนควบคุม แต่ขับเคลื่อนด้วย AI agent ทำหน้าที่สร้างเครื่องมือ หรือ agent ที่เฉพาะเจาะจงด้านต่าง ๆ ขึ้น เก็บรวบรวมข้อมูลแต่ละด้าน และค้นหาข้อมูลเพิ่มเติมเชิงลึกด้านนั้น ๆ ก่อนนำมาสรุป รวบรวม วิเคราะห์ให้ หรือมี agent ทำหน้าที่ generate สิ่งที่ต้องการเข้าด้วยกันเป็นเรื่องที่ตรงตามความต้องการของกลุ่มเป้าหมาย ซึ่งปีนี้จะมีผู้ใช้งานแน่เริ่มจากระบบเล็ก ๆ ก่อนขยายใหญ่ขึ้นในปีหน้า เช่น กระบวนการจัดซื้อจัดจ้างใช้ในการเปรียบเทียบราคา องค์กรที่ให้ความสนใจ ได้แก่ ธนาคาร ประกัน ค้าปลีก

- AI Governance ซึ่งการทำงานต้องมีจริยธรรม ตรวจสอบได้ถึงที่ไปที่มาของข้อมูล เป็นข้อมูลที่ละเมิดสิทธิส่วนบุคคลหรือไม่ สิ่งที่ AI ทำ บริษัทต้องรับผิดชอบความเสียหายที่จะเกิดขึ้นด้วย

- Disinformation Security การรักษาความปลอดภัยจากข้อมูลบิดเบือน เช่น คนร้ายนำ AI ไปใช้ในทางผิด เช่น คอลล์ เซ็นเตอร์ ดีปเฟค เป็นปัญหาที่ต้องเกิดขึ้นแน่จากการที่คนร้ายดึงซอร์สโค้ดโอเพ่นซอร์สมาใช้ แม้เป็นเรื่องแก้ยากแต่ต้องหาทางแก้ไข ด้วยความร่วมมือหลายฝ่าย เช่น รัฐบาลออกกฎหมายควบคุม การให้ความรู้แก่ประชาชน ส่วนบริษัทโทรคมนาคม พัฒนาซอฟต์แวร์บางตัวมาตรวจจับ Disinformation ให้แก่ผู้ใช้ก่อน ถือเป็นความรับผิดชอบร่วมกัน และหาแนวทางป้องกันระดับชาติ

แนะตั้งหน่วยงานกำกับดูแล

แนวทางป้องกันภัยจาก AI แนะนำให้ตั้ง AI governance Structure ในองค์กร เพื่อดูแลเรื่อง data governance ความเสี่ยงที่เกี่ยวข้องกับ AI เช่น กรณีเปิดให้คนเข้ามาใช้จะเสี่ยงด้านใด ก็ตั้งหน่วยงานที่รับผลกระทบขึ้นรับเรื่อง รับมือสถานการณ์อย่างรวดเร็ว

ปัจจุบัน กฎหมายที่เกี่ยวข้องมีเพียง พ.ร.บ.คุ้มครองข้อมูลส่วนบุคคล (PDPA) ควบคุมข้อมูลลูกค้าให้ปลอดภัย ไม่หลุด รั่ว แต่ในความเป็นจริงแล้วการหลุดของข้อมูล ตรวจสอบยาก ต้องหาหลักฐานมาก กรณีหลุด และฟ้องร้อง ต้องใช้เวลาหาหลักฐานนาน แต่หากข้อมูลหลุดจริง และเป็นกรณีใหญ่ ผลกระทบมาก ต้องรวมตัวกันฟ้อง

การพัฒนาและกำกับดูแล AI

จากกรณีศึกษาในยุโรป วางแนวทางพัฒนาเอไอ 3 ระดับ คือ 1. ต้องมีความน่าเชื่อถือ และถ้าเกิดผิดพลาดจะต้องรับผิดชอบอย่างไร จริยธรรม นโยบายการพัฒนา AI ขึ้น การใช้เครื่องไม้เครื่องมือ ทำขึ้นมาแล้วส่งผลต่อสังคม ประชาชนอย่างไร เช่น การพัฒนา AI เพื่อคัดกรองคนเข้าทำงาน ข้อมูลที่นำมาใช้คัดกรองต้องไม่มีอคติ ซึ่งเคยมีเคสของอะเมซอนจะครอบคลุมผู้ชายมากกว่า พอหญิงส่งเรซูเม่ไปจะถูกรีเจ็กต์ ต้องดูไม่ให้โมเดลเบี่ยงเบน

2. ต้องมีนโยบายควบคุมการพัฒนาโครงการ AI คนที่อยู่ในโครงการต้องทราบว่า ความเสี่ยงคืออะไร จะใช้เครื่องมือ หรือข้อมูลอะไรบ้าง ทุกคนต้องรับทราบ และปิดความเสี่ยงเหล่านั้นได้ ซึ่งความเสี่ยงนั้น ๆ เกี่ยวกันกับเทคโนโลยีเอไอด้วย เช่น การใช้ข้อมูลส่วนบุคคล ที่สร้างเทคโนโลยี AI ต้องควบคุมการเข้าถึงฐานข้อมูลนี้ เช่น เข้ารหัสข้อมูล ตรวจสอบว่า ใครมีสิทธิเข้าถึงข้อมูลนี้ได้บ้าง เพื่อการตรวจสอบในอนาคตหากข้อมูลหลุดรั่วจะได้ตรวจสอบได้ว่า ใครเข้ามาบ้าง

3. Attributes of Governance Platforms AI ต้องโปร่งใส สามารถระบุได้ว่า AI นั้น ๆ พัฒนามาโดยใช้ข้อมูลอะไร มีเงื่อนไข ขั้นตอนอะไรบ้าง และถ้าเกิดความเสียหายจากเอไอนี้ต้องมีผู้รับผิดชอบ และจะรับผิดชอบอย่างไร โดยเอไอต้องไม่อคติ ต้องทดสอบด้วยข้อมูลที่เป็นกลางจริง และไม่ละเมิดข้อมูลส่วนบุคคล โดยต้องควบคุมอย่างชัดเจน

องค์กรทั่วโลกลงทุน AI

ผลสำรวจข้อมูลของการ์ทเนอร์ ระบุว่า การนำ AI ไปใช้งานในองค์กรทั่วโลก ปี 2024 แม้ยังมีข้อจำกัดด้านการบริหารความเสี่ยง โดย 58% ขององค์กรทางการเงินกำลังใช้ AI

แบ่งเป็น 32% อยู่ในขั้นกำลังพัฒนา 20% ใช้ AI แล้ว 6% ขยายการใช้งานสู่ผู้ใช้กลุ่มใหญ่ ขณะที่องค์กร 21% กำลังติดตั้ง AI ส่วนที่เหลือเป็นกลุ่มที่ยังไม่มีแผนด้าน AI ซึ่งองค์กรในไทยก็มีผลลัพธ์ไปในทิศทางเดียวกับระดับโลก

ระวังผลกระทบต่อสังคม-ระบบต้องปลอดภัย

ข้อควรระวังในการตัดสินใจลงทุน AI คือ 1. Ethical and Societal Impact ผลกระทบด้านจริยธรรม สังคม การนำไปใช้ในทางที่ผิด การสร้างโมเดลเอไอที่มีอคติ 2. Data Security and Privacy ความปลอดภัยและความเป็นส่วนตัวของข้อมูล ดังนั้น ต้องมีระบบป้องกัน ควบคุมอย่างชัดเจน รวมถึงกำหนดผู้เข้าถึงข้อมูล และระดับการเข้าถึง

3. Resource Validation การที่ AI แยกแยะอคติในข้อมูลไม่ได้ จะนำไปสู่ผลลัพธ์ที่ไม่ถูกต้อง 4. Transparency โมเดลที่ซับซ้อนของ generative AI อาจทำให้เข้าใจผิดพลาด ส่งผลต่อผลลัพธ์ที่ได้ จึงควรต้องอัปเดตข้อมูล และโมเดลตลอดเวลา ตลอดจนการคำนึงถึงเรื่องความปลอดภัยทางไซเบอร์ ต้องตรวจสอบได้ว่า มีใครกำลังเข้าใช้งานบ้าง ใครกำลังเจาะข้อมูล และติดตั้งระบบป้องกัน

ผู้ใช้ต้องรู้เท่าทัน-กำหนดรหัสลับ

ในขณะที่การพัฒนา AI กำลังก้าวไปข้างหน้า ผู้ใช้งานก็ต้องระมัดระวังตัวเอง และการอยู่ในสังคมสูงวัย ซึ่งเป็นหนึ่งในกลุ่มเปราะบาง เสี่ยงต่อการถูกหลอกลวง ดังนั้น จึงแนะนำว่า ต้องให้ความรู้ และอาจต้องกำหนดรหัสลับเพื่อการยืนยันตัวตนแบบหลายปัจจัย (Multi-Factor Authentication) เป็นข้อตกลงร่วมกันภายในครอบครัว

อย่างไรก็ตาม ในอนาคตโทรศัพท์มือถือจะฝังซอฟต์แวร์ช่วยการตรวจสอบเข้าไป เพื่อช่วยป้องกันการถูกหลอกขั้นหนึ่งก่อน

ข่าวอื่น ๆ ที่น่าสนใจ

ความท้าทายและโอกาสในการเปลี่ยนแปลงการศึกษาของประเทศไทย

Block Mountain CNX 2025 อัปเดตเทรนด์ Blockchain และ Web3 ที่น่าจับตามอง

ถ้าเอ็นเตอร์เทนเมนต์ คอมเพล็กซ์มา โฉมหน้าเมืองเทวดาจะเป็นเช่นไร?